Si les rumeurs de l’industrie sont fondées, la suite du géant de la technologie open-source pourrait sortir au début de l’année 2024.

Meta n’a pas officiellement confirmé ces rumeurs, mais Mark Zuckerberg a récemment fait la lumière sur l’avenir des LLM (Large Language Models) de Meta, en commençant par reconnaître que Llama 3 est en cours de développement. Il a toutefois précisé que le nouveau modèle d’IA sous-jacent était toujours en attente et que la priorité était d’affiner Llama 2 pour le rendre plus convivial.

« Je veux dire que nous sommes encore en train de former le prochain modèle », a-t-il déclaré lors d’une interview podcast sur l’intersection entre l’IA et le métavers. « Nous avons formé et publié Llama 2 en tant que modèle open-source, et il est maintenant nécessaire de l’intégrer dans une sorte de produit grand public …….. ».

« Mais oui, nous travaillons également sur les futurs modèles de la Fondation et je n’ai pas de nouvelles à ce sujet », a-t-il poursuivi. Je ne sais pas exactement quand il sera prêt.

Bien que Meta n’ait pas officiellement confirmé les rumeurs, les modèles du cycle de développement et les investissements matériels importants suggèrent que l’entreprise est proche de sortir un nouveau produit. llama 1 et llama 2 sont sortis à six mois d’intervalle, et si ce rythme est maintenu, le nouveau llama 3 (qui devrait être au niveau OpenAI GPT-4) pourrait sortir au cours du premier semestre 2024.

L’utilisateur de Reddit, llamaShill, a fourni une analyse détaillée des cycles de développement historiques du modèle Meta, alimentant ainsi les spéculations.

L’utilisateur suggère que l’entraînement du Llama 1 a duré de juillet 2022 à janvier 2023, avec le Llama 2 juste après jusqu’en juillet 2023, ce qui rend probable que l’entraînement du Llama 3 se déroulera de juillet 2023 à janvier 2024. Ces résultats coïncident avec l’histoire de l’IA supérieure de Meta, et l’entreprise est impatiente de présenter sa prochaine avancée, qui peut rivaliser avec les capacités du GPT-4.

Entre-temps, les forums technologiques

et les médias sociaux ont été inondés de discussions sur la façon dont la nouvelle version pourrait restaurer l’avantage concurrentiel de Meta. La communauté technologique a également compilé un calendrier possible à partir de bribes d’informations.

Évalué lors de la conférence GenAI Social de Meta :

« Nous avons effectué des calculs de formation sur les Llamas 3 et 4. Le plan est que le Llama-3 est aussi bon que le GPT-4. »

« Wow, si Llama-3 est aussi bon que GPT-4, continuerez-vous à le mettre en open source ? »

« Oui, nous le ferons. Désolé, aligneur ».

– jason (@agikoala) 25 août 2023

Plus un petit détail sur Twitter : une conversation qui aurait été entendue lors d’une réunion sociale de « Meta GenAI » et publiée plus tard sur Twitter par Jason Way, chercheur à l’OpenAI. Selon Jason Way, « nous disposons déjà de la base de calcul nécessaire à l’entraînement des Lamas 3 et 4 » et une source non identifiée a confirmé qu’elle serait disponible en open source.

Entre-temps, l’entreprise s’est associée à Dell pour mettre Llama 2 à la disposition des utilisateurs professionnels, soulignant ainsi son engagement en faveur de la protection de la vie privée et de la sécurité, une démarche à la fois stratégique et simultanée. Cet engagement est crucial car Meta se prépare à affronter des géants tels qu’OpenAI et Google.

Meta intègre également l’intelligence artificielle dans un grand nombre de ses produits, il est donc logique que l’entreprise redouble d’efforts pour ne pas se laisser distancer. llama 2 est alimenté par Meta AI, ainsi que par d’autres services tels que Meta Chatbot, Meta Generation Service et Meta Artificial Intelligence Glasses.

Dans ce maelström de spéculations, les réflexions de Mark Zuckerberg sur l’open source llama 3 ne font que fasciner et mystifier ». Dans un récent podcast avec l’informaticien Lex Friedman, Mark Zuckerberg a déclaré : « Nous avons besoin d’un processus pour le refaire et le sécuriser.

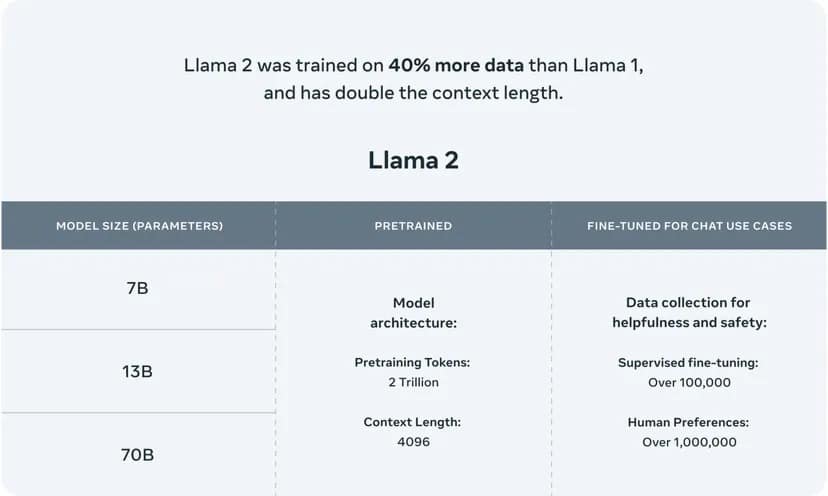

Llama 2 utilise une architecture à plusieurs niveaux qui propose des versions avec 7, 13 et 70 milliards de paramètres, chacune adaptée à différents niveaux de complexité et de puissance de calcul. Les paramètres du LLM agissent comme des blocs neuronaux qui déterminent la capacité du modèle à comprendre et à générer du langage, et le nombre de paramètres est souvent en corrélation avec la complexité et la qualité potentielle des résultats du modèle.

Ce puissant modèle d’IA a été entraîné sur un vaste corpus de 2 000 milliards de mots, ce qui confirme sa capacité à naviguer et à générer des textes semblables à ceux d’un être humain dans un large éventail de sujets et de contextes.

Image courtesy of Meta

.