Meta公司周四展示了两款最新的人工智能工具–Emu Video和Emu Edit,这两款工具是9月份在Meta Connect大会上发布的技术的首次亮相。Emu Video 是一款可让用户根据纯文本提示创建视频的工具,而 Emu Edit 则引入了一种不同的图像编辑方法,即内绘(inpainting)

。

今天,我们将分享生成式人工智能研究的两项新进展: Emu Video & Emu Edit。

详情 ➡️ https://t.co/qm8aejgNtd

这些新模型在高质量、基于扩散的文本到视频生成和受控图像编辑(含文本指令)方面取得了令人振奋的成果。

– AI at Meta (@AIatMeta) 2023年11月16日

。

推出 Emu Video 和 Emu Edit 是 Meta 的一项战略举措,Meta 表示这仍然符合其对 Metaverse 的更广泛愿景。该公司表示,这些工具提供了新的创意功能,旨在吸引从专业内容创作者到那些单纯寻求新颖方式表达想法的用户等广泛用户。

Emu Video 尤其体现了公司对推动人工智能驱动的内容生成的承诺,而且可能成为 Runway 和 Pika Labs 等热门公司的主要竞争对手,这些公司迄今为止一直在该领域占据主导地位。

Emu Video:从文本到视频的创作

。

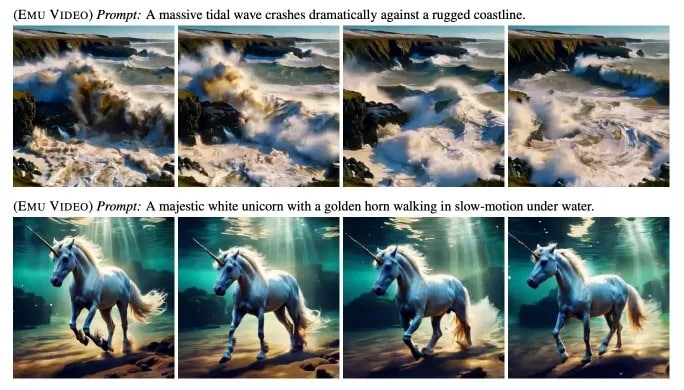

Emu Video 采用两步法根据文字提示创建视频。它首先根据输入的文本生成图像,然后根据文本和生成的图像制作视频。这种方法简化了视频生成过程,避免了 Meta 之前的 Make-A-Video 工具所使用的复杂、多模型方法。

Emu Video 创建的视频分辨率仅限于 512×512 像素,但与所提供的文字提示非常一致。精确地将文本转换为视觉叙事,使 Emu Video 有别于大多数现有模型和商业解决方案。

虽然模型本身并不公开,但用户可以使用一组预先确定的提示进行实验,结果相当流畅,帧与帧之间的差异最小。

Emu Edit:用内画法编辑图像

。

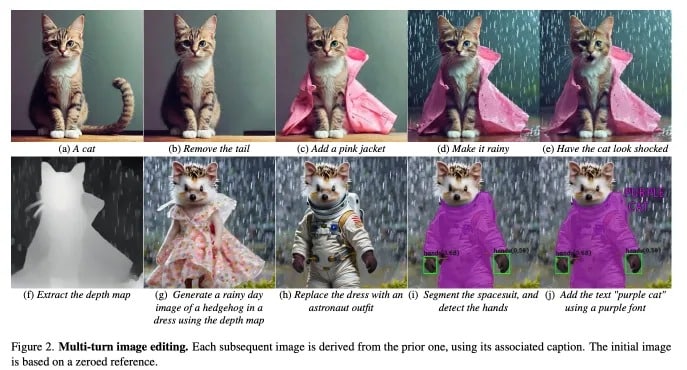

除了 Emu Video,Meta 还展示了 Emu Edit 的功能,这是一款人工智能驱动的工具,可根据人工智能对自然语言指令的解释执行各种图像编辑任务。Emu Edit 允许用户以高精度和高灵活性编辑图像。

“Emu Edit[是]一种多任务图像编辑模型,它在基于指令的图像编辑方面创造了最先进的成果,”Meta公司关于该工具的研究论文称,强调了它准确执行复杂编辑指令的能力。

Emu Edit 通过使用扩散器(一种先进的人工智能技术,由稳定扩散技术推广应用)提高了精确度。这种方法可确保编辑保持原始图像的视觉完整性。

Meta 专注于开发 Emu Video 和 Emu Edit 等人工智能工具,体现了其创造对创建 Metaverse 至关重要的技术的战略。这包括开发由 LLaMA-2 大型语言模型驱动的个人助理 Meta AI,以及在 AR 设备中引入多模态技术。