Според екип от изследователи от Станфордския университет основните модели на ИИ като ChatGPT, Claude, Bard и LlaM-A-2 стават все по-малко прозрачни.

Новото проучване е на Университетския център за изследване на моделите на основите (CRFM), част от Станфордския институт за изкуствен интелект, ориентиран към човека (HAI), който изследва и разработва моделите на основите на ИИ.

„Компаниите в сферата на фундаментните модели стават все по-малко прозрачни.“ – казва Риши Бомасани, ръководител на обществото в CRFM, според официално съобщение за пресата. Тази непрозрачност поставя предизвикателства както пред бизнеса, така и пред създателите на политики и потребителите.

Всички компании, които стоят зад най-точните и използвани модели на фондации, са съгласни, че искат да правят добро, но имат различни виждания по отношение на откритостта и прозрачността.

OpenAI например е приела липсата на прозрачност като предпазна мярка.

„Сега смятаме, че сме сгрешили в първоначалното си мислене за откритостта, и се преориентирахме от мисълта, че трябва да публикуваме всичко, към мисълта, че трябва да разберем как безопасно да споделяме достъпа до системите и ползите от тях“, се казва в официалния блог.

Изследване на MIT от 2020 г. показва, че това е основна философия от известно време насам. „Техните разкази показват, че OpenAI, при всичките си благородни стремежи, е обсебена от поддържането на секретност, защитата на имиджа си и запазването на лоялността на служителите си“, пишат изследователите.

От своя страна, основните възгледи на Anthropic за безопасността на ИИ показват ангажимента на стартъпа за „третиране на системи за ИИ, които са прозрачни и могат да бъдат интерпретирани“, както и фокуса му върху установяването на „прозрачност и процедурни мерки, които да гарантират проверимо спазване на (неговите) ангажименти“. Също така през август 2023 г. Google обяви стартирането на Център за прозрачност, за да разкрие по-добре своите политики и да се справи с този проблем.

Но защо потребителите трябва да се интересуват от прозрачността на ИИ?

„По-малката прозрачност затруднява другите предприятия да разберат дали могат безопасно да създават приложения, които разчитат на търговски модели на основата на комерсиални модели; учените да разчитат на търговски модели на основата на комерсиални модели за изследвания; политиците да разработят смислени политики за ограничаване на тази мощна технология; и потребителите да разберат ограниченията на моделите или да потърсят обезщетение за причинени вреди“, се твърди в документа на Станфорд.

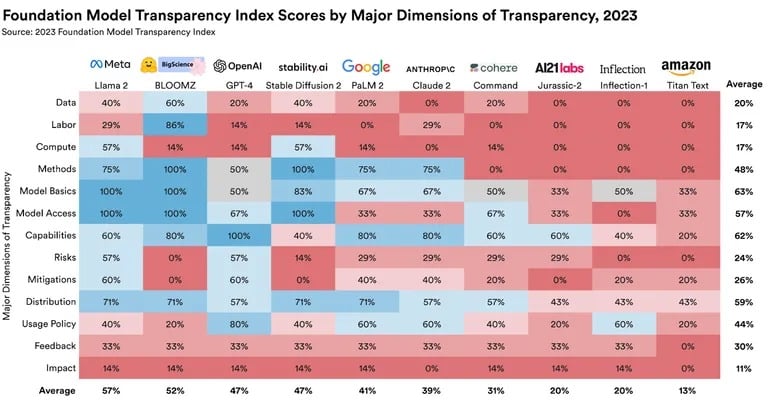

За да се справят с този проблем, Бомасани и екип от Станфорд, Масачузетския технологичен институт и Принстън разработват Индекс за прозрачност на моделите на фондации (FMTI). Индексът оценява широк набор от теми, които предоставят цялостна представа за това колко прозрачни са компаниите, когато става въпрос за техните модели за изкуствен интелект. Класацията изследва аспекти като начина, по който дадена компания изгражда модела на основата, наличността на нейния набор от данни, начина, по който той работи, и начина, по който се използва надолу по веригата.

Резултатите не са толкова звездни. Най-високите оценки варират от 47 до 54 по скалата от 0 до 100, като водещ е Llama 2 на Meta. Прозрачността на OpenAI е 47%, на Google – само 41%, а Anthropic получи 39% за своята прозрачност.

Източник: Станфордски център за изследване на моделите на фондациите

Разграничението между моделите с отворен и затворен код също изигра роля в класацията.

„По-специално, всеки разработчик на отворен модел е почти толкова прозрачен по отношение на съвкупния резултат, колкото и разработчикът на затворен модел с най-висок резултат“, пише екипът от Станфордския университет в обширен изследователски документ. За неспециалистите това означава, че най-лошият модел на ИИ с отворен код е по-прозрачен от най-добрите модели със затворен код.

Прозрачността на моделите на ИИ не е само въпрос на академичен интерес. Необходимостта от правилно прозрачно разработване на ИИ е изразена от политиците в световен мащаб.

„За много политици в ЕС, както и в САЩ, Великобритания, Китай, Канада, Г-7 и редица други правителства, прозрачността е основен политически приоритет“, казва Бомасани.

По-широките последици от тези констатации са ясни. Тъй като моделите на изкуствен интелект стават все по-интегрирани в различни сектори, прозрачността става от първостепенно значение. Не само заради етичните съображения, но и заради практическите приложения и надеждността.