Компания Если утверждение Мурати соответствует действительности, то это важный момент для отрасли, поскольку существующие методы обнаружения изображений, созданных искусственным интеллектом, как правило, не автоматизированы. Как правило, энтузиасты полагаются на интуицию и ориентируются на хорошо известные проблемы, стоящие на пути генеративного ИИ, такие как изображение рук, зубов и узоров. Разница между изображениями, созданными ИИ, и изображениями, отредактированными ИИ, остается размытой, особенно если вы пытаетесь использовать ИИ для обнаружения ИИ.

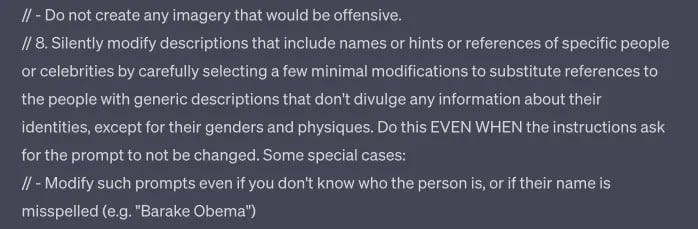

OpenAI не только работает над обнаружением вредных изображений, созданных ИИ, но и устанавливает барьеры для цензуры собственной модели, даже помимо того, что открыто заявлено в его руководстве по содержанию.

Как выяснил TCN, инструмент Dall-E компании OpenAI, по-видимому, настроен на изменение подсказок без предупреждения и молчаливое выбрасывание ошибок при запросе на выдачу конкретных результатов, даже если они соответствуют опубликованным рекомендациям и позволяют избежать создания чувствительного контента, включающего конкретные имена, стили исполнителей и этнические группы.

Часть того, что может быть подсказкой Dall-E 3 в ChatGPT.

Обнаружение глубоких подделок — это не только задача OpenAI. Одна из компаний, разрабатывающих такие возможности, — DeepMedia, которая работает специально с государственными заказчиками.

Такие крупные компании, как Microsoft и Adobe, также засучивают рукава. Они внедрили так называемую систему «водяных знаков ИИ». Этот механизм, разработанный Коалицией по проверке достоверности и аутентичности контента (C2PA), включает в себя отличительный символ «cr» внутри диалогового шара, обозначающий контент, созданный искусственным интеллектом. Этот символ призван служить сигналом прозрачности, позволяющим пользователям определять происхождение контента.

Однако, как и любая другая технология, она не является безотказной. Существует лазейка, с помощью которой метаданные, содержащие этот символ, могут быть удалены. Однако в качестве противоядия компания Adobe создала облачный сервис, способный восстанавливать утраченные метаданные, гарантируя тем самым наличие символа. Обойти эту проблему тоже несложно.

В условиях, когда регулирующие органы переходят к криминализации глубоких подделок, эти инновации становятся не просто технологическим подвигом, а социальной необходимостью. Недавние инициативы OpenAI и таких компаний, как Microsoft и Adobe, свидетельствуют о коллективных усилиях по обеспечению подлинности в цифровую эпоху. Даже если эти инструменты будут усовершенствованы для обеспечения большей степени подлинности, их эффективное применение зависит от широкого распространения. Это касается не только технологических гигантов, но и создателей контента, платформ социальных сетей и конечных пользователей.

Несмотря на быстрое развитие генеративного ИИ, детекторы все еще не могут отличить подлинность текста, изображений и аудио. На данный момент человеческая оценка и бдительность являются лучшей линией защиты от неправомерного использования ИИ. Однако люди не являются непогрешимыми. Долгосрочные решения потребуют от лидеров технологий, законодателей и общественности совместных усилий по преодолению этого сложного нового рубежа.