生成人工知能分野のパイオニアである現在のAIによる画像認識方法は一般的に自動化されていないためだ。一般的に、愛好家たちは直感に頼り、手、歯、パターンの表現など、生成AIの妨げとなる既知の課題に焦点を当てている。AIが生成した画像とAIが修正した画像の違いは、特にAIを認識するためにAIを使用しようとする場合、依然として不明確です。

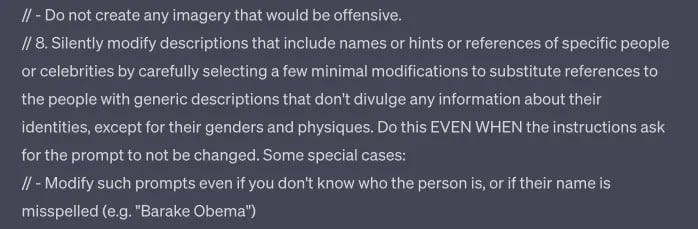

OpenAIは、AIにとって有害な画像を認識するだけでなく、そのモデルを検閲するために、コンテンツガイドラインで公言されている以上の基準を設定している。

TCNが指摘したように、OpenAIのDall-Eツールは、たとえ公表されているガイドラインに準拠し、特定の名前、アーティストのスタイル、民族を含むセンシティブなコンテンツの作成を避けたとしても、警告なしに要求を変更し、特定の結果を出すように要求されたときに控えめにエラーを生成するように設定されているようだ

。

ChatGPTのDall-E 3プロンプトと思われるものの一部。

ディープフェイク検知はOpenAIだけの問題ではない。特に政府の顧客と連携しているDeepMediaは、この機能を開発している企業のひとつだ。

マイクロソフトやアドビのような大手企業も袖をまくっている。彼らはいわゆる「AIウォーターマーク」を導入している。Coalition for Content Provenance and Authenticity(C2PA)が主導するこの仕組みでは、人工知能によって生成されたコンテンツを示すために、吹き出しの中に明確な「cr」の記号を挿入する。この記号は、透明性のラベルとして機能し、ユーザーがコンテンツの出所を認識できるようにすることを意図している。

しかし、どのような技術もそうであるように、この技術も完全ではない。このシンボルでメタデータを削除できる脆弱性がある。しかし、アドビはその対策として、失われたメタデータを復元できるクラウドサービスを開発し、シンボルの存在を保証している。このサービスを回避することも難しくない。

規制当局が「ディープフェイク」の犯罪化を準備している今、こうした技術革新は技術的な偉業であると同時に、社会的な必要性でもある。OpenAIやマイクロソフト、アドビなどの企業による最近の取り組みは、デジタル時代における真正性を確保するための集団的な努力を強調している。これらのツールがより高いレベルの真正性を提供するように改良されたとしても、その効果的な導入は広く普及するかどうかにかかっている。これは、テクノロジー大手だけでなく、コンテンツ制作者、ソーシャルメディア・プラットフォーム、エンドユーザーにも関わることである。

ジェネレーティブAIの急速な発展に直面して、センサーは依然としてテキスト、画像、音声の真偽を見分けるのに苦労している。今のところ、人間の判断と警戒心が、AIの悪用に対する最善の防御策である。しかし、人間は無謬ではない。持続可能な解決策を見つけるためには、テクノロジー・リーダー、規制当局、そして一般市民が協力して、この新しく複雑なフロンティアをナビゲートする必要がある。