Microsoft Researchは、小型言語モデル(SLM)であるPhi-2のリリースを発表した。本日発表されたこのモデルは、マイクロソフトのIgnite 2023イベントで初めて公開され、サティア・ナデラは、わずかな学習データで最先端の性能を達成する能力を強調した。

GPTやGemini、その他の大規模言語モデル(LLM)とは異なり、SLMは限られたデータセットで学習されるため、使用するパラメータは少ないが、実行に必要な計算量も少ない。その結果、このモデルは大規模言語モデルほど汎化できないが、Phiの場合は数学や計算のような特定のタスクでは非常に優秀で効率的である。

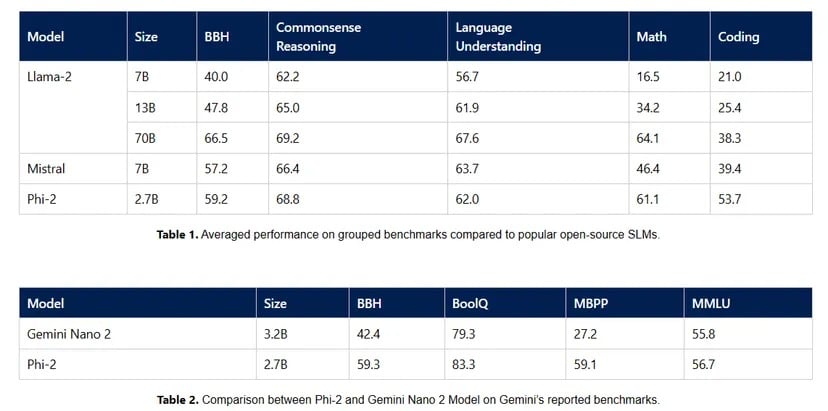

マイクロソフト社によれば、27億個のパラメータを持つPhi-2は、その25倍の大きさのモデルに匹敵する優れた推論能力と言語理解能力を示している。これは、マイクロソフト・リサーチが高品質のトレーニングデータと高度なスケーリング技術に注力したことに起因しており、数学、コーディング、常識的な推論を含む様々なベンチマークにおいて、先行モデルを凌駕するモデルを生み出した。

「わずか27億のパラメータで、Phi-2は様々なベンチマークで7Bと13Bのパラメータを持つMistralとLlama-2モデルの性能を上回った」とマイクロソフトは述べ、グーグルの最新AIモデルに一撃を加えた: 「さらに、Phi-2はサイズが小さいにもかかわらず、最近発表されたGoogle Gemini Nano 2に匹敵するか、上回っている。

Source: マイクロソフト

Gemini Nano 2は、ローカルで動作可能なマルチモーダルLLMに対するグーグルの最新の賭けである。このLLMは、グーグルのほとんどのサービスでPaLM-2に取って代わると期待されているLLMのGeminiファミリーの一部として発表された。

しかし、マイクロソフトのAIへのアプローチはモデル開発にとどまらない。TCNが報じたカスタムチップ、MaiaとCobaltの導入は、同社がAIとクラウドコンピューティングを完全に統合する方向に向かっていることを示している。AIタスク用に最適化されたこのコンピューターチップは、ハードウェアとソフトウェアの能力を調和させるというマイクロソフトの大きなビジョンをサポートし、グーグルのTensorやアップルの新しいMシリーズのチップと直接競合するものだ。

Phi-2が非常に小さな言語モデルであるため、低階層の機器(スマートフォンの可能性さえある)でローカルに実行することができ、新たなアプリケーションやユースケースへの道を開くことができることに注目することは重要である。

Phi-2がAIの研究開発の領域に入り、Azure AI Studioのモデルカタログで利用できるようになったことは、AI研究の民主化に向けた一歩でもある。マイクロソフトは、オープンソースのAI開発に最も積極的に貢献している企業の1つです。

AIの展望が進化し続ける中、マイクロソフトのPhi-2は、AIの世界が常に大きく考えることではないという証拠である。時には、より小さく、より賢くなることが最大の力を発揮することもあるのだ

。