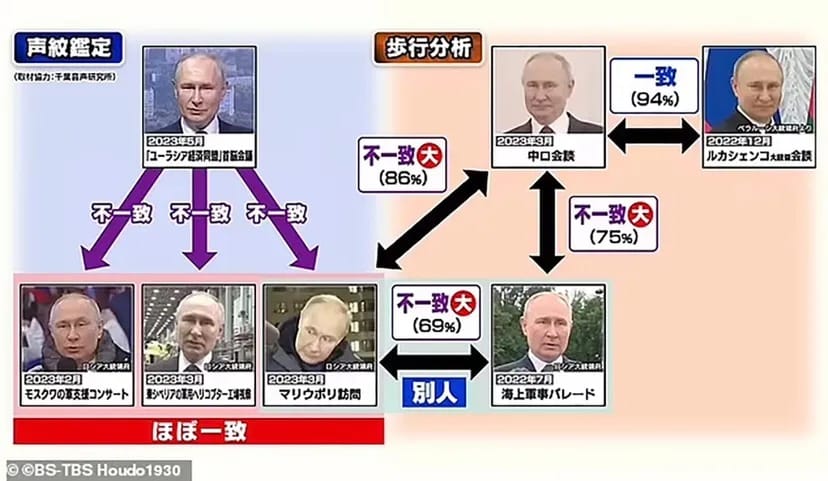

Сегмент от японска новинарска емисия съживи слуховете, че Владимир Путин използва двойници за публични изяви, а генеративният изкуствен интелект уж се използва, за да направи снимките на тези двойници по-подобни на истинския руски президент.

Упоритото и непотвърдено твърдение се разпространява от месеци и отново се появи в Япония, според доклад на Daily Mail. Според съобщението японски изследователи са анализирали видеоматериали и снимки на Путин на различни събития и са предположили, че има поне трима души, които го играят. Въпреки че подобни твърдения незабавно се отхвърлят от Кремъл, историята все пак илюстрира един страничен ефект от бързия напредък в областта на изкуствения интелект: напредъка в дълбоките фалшификации на изкуствения интелект.

Дълбоките фалшификати с изкуствен интелект са технология, която използва алгоритми за подмяна на лица във видеоклипове, изображения и друго цифрово съдържание, за да накара фалшификатите да изглеждат истински. Дълбоките фалшификати са признати за опасен нов инструмент за политическа манипулация. Откриването на дълбоки фалшификати се превърна в бързо развиваща се индустрия, като OpenAI – лидер в областта на генеративния изкуствен интелект – твърди, че може да идентифицира дълбоки фалшификати с 99% точност.

Но изследователите казват, че това не е лесно – и ще продължи да става все по-трудно.

Японската телевизионна мрежа TBS съобщи, че е отразила изследване, базирано на ИИ, което предполага, че руският президент Владимир Путин използва двойници, за да присъства на различни събития. Изображение: Daily Mail

„Във вероятностната технология има опити да се определи дали нещо е изкуствен интелект“, заяви президентът и главен изпълнителен директор на Digimarc Райли Маккормак пред TCN. „Мисля, че сте видели, че ако разгледате много от тези методи, най-добрите от тях са с доста ниска точност.“

Стартирала през 1994 г., Digimarc предоставя цифрови водни знаци, които помагат за идентифициране и защита на цифрови активи и собственост върху авторски права. Водните знаци са един от най-често предлаганите начини за идентифициране на дълбоки фалшификати и компании като Google проучват този подход.

По време на Google Cloud Next в Сан Франциско Alphabet и главният изпълнителен директор на Google Сундар Пичай представиха функция за водни знаци в платформата за изкуствен интелект Google Vertix.

„Използвайки технология, задвижвана от Google Deepmind, изображенията, генерирани от Vertix AI, могат да бъдат маркирани с воден знак по начин, който е невидим за човешкото око, без да се нарушава качеството на изображението“, каза Пичай.

Като стратегия обаче водният знак има редица слабости. А Маккормак заяви, че спирането на дълбоките фалшификати на ИИ с воден знак изисква всички да приемат един и същ метод за обозначаване дали нещо е генерирано от ИИ или е автентично – нещо, което той е твърдял и преди.

„Проблемът с това да се прави единствено генеративен ИИ с воден знак е, че не всеки генеративен ИИ двигател ще го приеме“, каза той. „Проблемът с всяка система за автентичност е, че ако нямате повсеместност, само маркирането по един начин не прави нищо.“

Тъй като генераторите на изображения с ИИ черпят от свободно достъпни изображения от интернет и социалните медии, други експерти препоръчват да се включи код, който да влошава изображението в генератора, или да се използва отровно хапче чрез неправилно маркиране на данните, така че когато те се подадат към модела на ИИ, ИИ да не е в състояние да създаде желаното изображение и потенциално да се срине под напрежението.

Създадени са дълбоки фалшификати на ИИ, които подправят президента на САЩ Джо Байдън, папа Франциск и бившия президент Доналд Тръмп. Тъй като технологията за дълбоки фалшификати се усъвършенства с всеки изминал ден, детекторите на изкуствен интелект са принудени да играят на „уак-а-моле“ в надпреварата да не изостават.

Към опасностите от дълбоките фалшификати с изкуствен интелект се прибавя и увеличаването на генерираните от изкуствен интелект материали за деца и възрастни (CSAM). В доклад, публикуван през октомври от британската група за наблюдение на интернет Internet Watch Foundation, се посочва, че детската порнография се разпространява бързо онлайн с помощта на модели с отворен код на ИИ, които са свободни за използване и разпространение.

IWF предполага, че дълбоко фалшивата порнография е напреднала до степен, в която различаването на изображения на деца, генерирани от изкуствен интелект, от реални изображения на деца става все по-трудно, което кара правоприлагащите органи да преследват онлайн фантоми вместо действителни жертви на насилие.

„Така че е налице това продължаващо нещо, че не можеш да се довериш на това дали нещата са истински или не“, каза пред TCN главният технически директор на Internet Watch Foundation Дан Секстън. „Нещата, които ще ни кажат дали нещата са истински или не, не са 100% и следователно не можете да им се доверите.“

Друг въпрос, който Маккормак повдигна, е, че много от моделите на ИИ на пазара са с отворен код и могат да се използват, модифицират и споделят без ограничения.

„Ако поставяте техника за сигурност в система с отворен код – каза Маккормак. „Вие поставяте там ключалка, а точно до нея поставяте проекта за това как да отключите ключалката, така че това всъщност не добавя много стойност.“

Секстън каза, че е оптимист за едно нещо, когато става въпрос за моделите за генериране на образи: тъй като по-големите модели като „Стабилна дифузия“, „Миджурней“ и „Дал-Е“ стават по-добри и запазват силни предпазни огради, тогава по-старите модели, които позволяват локално създаване на CSAM, ще излязат от употреба. Също така ще бъде по-лесно да се определи кои модели са създали изображенията – каза той.

„Ще се стигне до момент, в който ще бъде по-трудно да се правят тези неща, много по-нищожно да се правят тези неща и потенциално по-лесно да се насочват и предотвратяват тези вреди“, каза Секстън.

Докато правителствените лидери са основна мишена за дълбочинни фалшификати с изкуствен интелект, все повече холивудски знаменитости откриват, че подобието им се използва в онлайн измами и реклами, включващи дълбочинни фалшификати с изкуствен интелект.

В търсене на начин да спре неразрешеното използване на нейния образ, холивудската актриса Скарлет Йохансон заяви, че предприема правни действия срещу компанията за изкуствен интелект Lisa AI, която е използвала генерирано от изкуствен интелект изображение на звездата от „Отмъстителите“ в реклама. Миналия месец гигантът в YouTube г-н Звяр предупреди последователите си за онлайн измама, използваща неговия образ, и дори Том Ханкс стана жертва на кампания за дълбоко подправен ИИ, която използва образа му, за да рекламира, на всичкото отгоре, зъболекарски план.

През септември папа Франциск, обект на много дълбокофантастични фалшификати с изкуствен интелект, превърна технологията в централна тема на празнична проповед за Световния ден на мира. Религиозният лидер призова за открит диалог относно ИИ и неговото значение за човечеството.

„Забележителният напредък, постигнат в областта на изкуствения интелект, оказва бързо нарастващо въздействие върху човешката дейност, личния и социалния живот, политиката и икономиката“, каза Франциск.

Според Маккормак с усъвършенстването на инструментите за откриване на ИИ ще се усъвършенстват и генераторите на дълбоки фалшификати, което ще доведе до още един фронт на надпреварата във въоръжаването с ИИ, започнала с пускането на ChatGPT миналата година.

„Генеративният ИИ не е създал проблема с дълбоките фалшификати или проблема с дезинформацията“, каза Маккормак. „Той просто го демократизира.