W nieustannie zmieniającym się świecie technologii rzadko zdarza się, by inicjatywa Elona Muska nie wywoływała poruszenia, a kilka tygodni po wezwaniu do zakończenia uprawy LLM zdolniejszych niż GPT-4, Musk zrobił to, co jest dla niego typowe. Oto xAI, najnowszy wynalazek Muska, i Grok, nowy LLM ogłoszony w sobotę.

Zapowiedź Groka!

Grok to sztuczna inteligencja wzorowana na Przewodniku Autostopowicza po Galaktyce, która może odpowiedzieć na każde pytanie, a nawet zasugerować, jakie pytania należy zadać!

Grok został zaprojektowany, aby odpowiadać na pytania z humorem i ma buntowniczą stronę, więc nie używaj…

– xAI (@xai) 5 listopada 2023

Zasada była trzymana w tajemnicy. Przynajmniej do zeszłego tygodnia.

Czy jest to kolejne klasyczne posunięcie Muska mające na celu zakwestionowanie status quo, czy też jest to po prostu kolejny przereklamowany chatbot unoszący się na fali popularności i szumu, który otaczał jego poprzedników?

TheGood

Ciągły strumień wiedzy w czasie rzeczywistym

Dostęp do całego strumienia treści Twittera może sprawić, że Grok zmieni zasady gry. xAI zwraca uwagę, że Grok ma to, co badacze sztucznej inteligencji nazywają uczeniem się ze wzmocnieniem sprzężenia zwrotnego (RLHF) „wiedzą o świecie w czasie rzeczywistym”, przetwarzając bieżące wiadomości i różne komentarze. Robi to poprzez.

Ucząc się o wydarzeniach z różnych punktów widzenia i robiąc notatki ze społeczności Twittera (która zasadniczo składa się z komentarzy), Grok skorzysta z wielowarstwowego spojrzenia na świat.

Ostatnie badania pokazują, że ludzie już zmieniają swoje zachowanie, aby wyszukiwać wiadomości w mediach społecznościowych przed zwróceniem się do tradycyjnych mediów; integracja Grok z Twitterem jeszcze bardziej przyspieszy ten proces, zapewniając użytkownikom natychmiastowy komentarz i kontekst oraz, miejmy nadzieję, fakty na miejscu xAI zwróciło uwagę, że funkcja wiedzy w czasie rzeczywistym pozwala Grok być na bieżąco z globalnymi wydarzeniami i zapewniać aktualne i trafne odpowiedzi

Tryb fana: spełnienie marzeń Elona

Wizja Elona Muska o kochającej zabawę sztucznej inteligencji wydaje się być urzeczywistniona dzięki tak zwanemu „trybowi zabawy” Groka. Funkcja ta pozwala LLM opowiadać dowcipy, udzielać dowcipnych, ale poprawnych odpowiedzi i zapewniać użytkownikom zabawne i swobodne doświadczenie konwersacyjne.

Jednym z wyzwań stawianych przez istniejące platformy LLM, takie jak ChatGPT, jest to, że niektórzy użytkownicy mogą czuć się nadmiernie naciskani, aby zapewnić poprawność polityczną, co może skutkować tym, że interakcje stają się mniej organiczne i spontaniczne. Co więcej, niektóre lokalne LLM nie nadają się do długotrwałej interakcji, a Grok obiecuje wypełnić tę lukę swoim trybem zabawy i służyć jako wciągająca rozrywka dla tych, którzy chcą się zrelaksować.

Grok zapewnia dostęp do informacji w czasie rzeczywistym za pośrednictwem platformy ᵔ.

Opiera się również na &. ♂️ pic.twitter.com/e5OwuGvZ3Z

– Elon Musk (@elonmusk) 4 listopada 2023

Koncepcja ta nie jest całkowicie nowa – Poe firmy Quora oferuje podobną usługę z precyzyjnie dostrojonymi chatbotami, z których każdy ma własną osobowość. Jednak integrując funkcjonalność Grok z LLM, doświadczenie osiąga nowy poziom.

Natywny dostęp do Internetu

Jednym z innych wyróżników Grok jest możliwość dostępu do Internetu bez konieczności stosowania wtyczek lub innych modułów.

Dokładny zakres funkcji przeglądania nie został jeszcze określony, ale pomysł jest atrakcyjny. Wyobraźmy sobie LLM, który może poprawić dokładność faktów dzięki możliwości porównywania danych w czasie rzeczywistym – Grok, wraz z dostępem do treści na Twitterze, może zrewolucjonizować sposób interakcji użytkowników ze sztuczną inteligencją. Wynika to z faktu, że użytkownicy będą wiedzieć, że informacje, które otrzymują, są nie tylko oparte na istniejących danych szkoleniowych, ale są stale aktualizowane i weryfikowane.

Multitasking

Grok ma być wielozadaniowy, umożliwiając użytkownikom prowadzenie wielu rozmów w tym samym czasie. Użytkownicy mogą badać różne tematy, czekać na odpowiedź w jednym wątku i kontynuować w innym.

Chatbot ma również możliwość rozgałęziania rozmów, umożliwiając użytkownikom zagłębianie się w określone obszary bez przerywania głównej dyskusji.

Grok zapewnia również zintegrowany edytor Markdown, umożliwiający użytkownikom pobieranie, edytowanie i formatowanie odpowiedzi Grok do późniejszego wykorzystania. Narzędzie to, w połączeniu z funkcją rozgałęziania, pozwala użytkownikom na pracę w określonych gałęziach konwersacji i płynne cofanie się.

Interfejs użytkownika Grok ma następujące funkcje. Po pierwsze, możliwa jest wielozadaniowość. Można prowadzić wiele konwersacji w tym samym czasie, przełączając się między nimi w trakcie pracy. pic.twitter.com/aXAG0M2oPF

– Toby Pohlen (@TobyPhln) 5 Nov 2023

Minimalna cenzura: swoboda wypowiedzi AI

Wizja Groka Elona Muska była jasna.

Wszystkie główne chatboty AI mają zabezpieczenia, aby uniknąć potencjalnej szkody lub dezinformacji, ale czasami może to być ograniczeniem: użytkownicy zauważyli, że modele takie jak ChatGPT, Llama i Claude wstrzymują odpowiedzi, aby uniknąć potencjalnego obrażenia Użytkownik jest tego świadomy. Może to jednak wykluczyć nieszkodliwe lub naprawdę pożądane odpowiedzi.

Grok jest bardziej swobodny w swoich odpowiedziach, zapewniając bardziej autentyczne i swobodne doświadczenie konwersacyjne. xAI zwraca uwagę, że dzięki swojej konstrukcji Grok może odpowiadać na znaczące pytania, które inne systemy sztucznej inteligencji zignorowałyby

Prezentacja Grok!

Grok to galaktyczna sztuczna inteligencja w stylu przewodnika autostopowego, która może odpowiedzieć na prawie wszystko, a co gorsza, może zasugerować, jakie pytania należy zadać!

Grok został zaprojektowany, aby odpowiadać na pytania z humorem i ma buntowniczą stronę, więc nie używaj…

– xAI (@xai) 5 listopada 2023

Oczywiste jest, że ta sztuczna inteligencja oferuje unikalne połączenie informacji w czasie rzeczywistym, humoru, dokładności i wolności. Jednak, jak w przypadku każdej innowacji, istnieją wyzwania i potencjalne pułapki do rozważenia.

evil

Szybki wzrost i ograniczone szkolenia

Szybki rozwój Groka od samego początku budził pewne obawy: jak wyjaśniła firma xAI, „Grok był wciąż bardzo wczesnym produktem w wersji beta i dwa miesiące szkolenia to wszystko, co mogliśmy zrobić”; w świecie LLM dwa miesiące i 33 miliardy parametrów wydają się kroplą w morzu.

Dla porównania, OpenAI jest przejrzyste w kwestii swojego procesu rozwoju, mówiąc, że spędziło sześć miesięcy na dostrajaniu GPT-4. Ta różnica w czasie rozwoju sugeruje, że rozwój Groka został przyspieszony, aby unieść się na fali AI.

Co więcej, x.AI milczy na temat zakresu sprzętu używanego do trenowania Groka, pozostawiając miejsce na spekulacje.

Wszystkie parametry

Dla niewtajemniczonych, w skrócie, parametr LLM reprezentuje ilość informacji lub wiedzy, którą model może przechowywać. Reprezentuje rzeczywistą pojemność mózgu sztucznej inteligencji i określa jej zdolność do przetwarzania i generowania informacji. 33 miliardy parametrów sprawiają, że Grok może wydawać się imponujący na pierwszy rzut oka.

Jednak w konkurencyjnym środowisku LLM, Grok jest tylko graczem. W rzeczywistości liczba parametrów może nie być wystarczająca do spełnienia złożonych wymagań biznesowych i zapewnienia wysokiej jakości wyników, które duże firmy, takie jak ChatGPT, Claude i Bard, ustanowiły jako złoty standard.

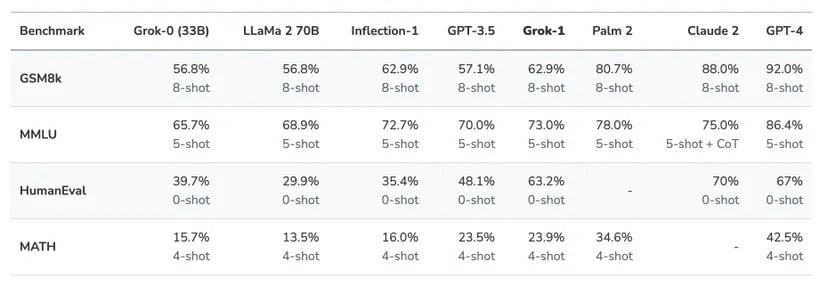

Częściowo z powodu tej niskiej liczby parametrów Grok nie jest w stanie pokonać innych modeli głównego nurtu w głównych testach porównawczych, takich jak HumanEval i MMLU:

Oprócz liczby parametrów pojawia się również kwestia obsługi kontekstu, tj. ile informacji chatbot AI może zrozumieć z danych wejściowych. grok nie jest szczególnie imponujący w tym obszarze, chociaż według xAI grok zawiera 8 192 tokeny kontekstowe, GPT-4 obsługuje 32 000, a Claude kolejne 100 000 tokenów kontekstowych; nowy GPT-4 Turbo OpenAI osiąga okno kontekstowe 128 000 tokenów

Koszt innowacji

Koszt jest kluczowym czynnikiem w ocenie wartości każdego produktu, a Grok nie jest wyjątkiem. Chatbot jest dostępny za miesięczną opłatą w wysokości 16 USD.

Biorąc pod uwagę bezpłatne oferty, takie jak Claude 2 i ChatGPT, które są oparte na GPT-3.5 Turbo, Grok może być trudny do sprzedania. Zwłaszcza biorąc pod uwagę, że te darmowe modele są wysoko cenione za swoją dokładność i już przewyższają Grok w niektórych testach porównawczych.

Co więcej, nawet najpotężniejszy LLM, GPT-4, ma tę zaletę, że jest szeroko dostępny, multimodalny i potężny, i zapowiada się lepiej niż Grok.

.

@xAI Grok AI Assistant jest oferowany w ramach ᵔ Premium+ i zaleca się rejestrację.

Tylko 16 USD miesięcznie przez Internet. https://t.co/wEEIZNjEkp

– Elon Musk (@elonmusk) 4 listopada 2023

Czy wprowadzenie Grok jest przede wszystkim strategicznym posunięciem mającym na celu zwiększenie liczby subskrybentów Twitter Blue i rozszerzenie strumienia przychodów Twittera?

Te obawy podkreślają, jak trudno jest Grok stać się głównym graczem w przestrzeni LLM. A wady wykraczają poza cenę.

Ugly

Fikcja pominięta

Użycie fikcyjnych postaci z popularnej fikcji jako modeli dla LLM jest bez wątpienia kreatywną decyzją. Chociaż urok fikcyjnych postaci może być atrakcyjny, wiąże się z ryzykiem w świecie, który w coraz większym stopniu polega na dokładnych informacjach. Użytkownicy zwracający się do sztucznej inteligencji z poważnymi pytaniami i poradami mogą dać się nabrać na systemy naśladujące postacie z komiksów.

Ponieważ granica między fikcją a rzeczywistością coraz bardziej się zaciera, istnieje również ryzyko, że użytkownicy mogą błędnie interpretować żarty lub satyryczne odpowiedzi jako prawdziwe informacje. W erze cyfrowej, gdzie wszystkie informacje są analizowane i udostępniane, konsekwencje takich nieporozumień mogą być daleko idące. Jest to szczególnie prawdziwe, gdy w grę wchodzi wiele języków.

Humor i dowcip mają swoje miejsce, ale ważne jest, aby zachować równowagę, zwłaszcza gdy użytkownicy szukają krytycznych spostrzeżeń. Przedkładanie humoru nad dokładność może być zabawne, ale może również umniejszać istotę tego, co LLM ma zapewnić – wiarygodne informacje.

Overpromise and underdeliver

Wielkie obietnice Elona Muska dotyczące Grok były bardzo obiecujące. Bliższe spojrzenie ujawnia potencjalną sprzeczność między szumem a rzeczywistością. Fakt, że tradycyjne metody szkoleniowe LLM są ograniczone przez dane szkoleniowe, podkreśla fundamentalne ograniczenie.

Przy 33 miliardach parametrów i zaledwie kilku miesiącach rozwoju, szkolenie Grok wydaje się nieistotne w porównaniu z innymi gigantami LLM. Podczas gdy idea zabawnej, fikcyjnej osobowości brzmi atrakcyjnie, oczekiwanie, że standardowe metody szkoleniowe mogą zapewnić rewolucyjne wyniki, może być nieco przesadzone.

Społeczność AI jest przyzwyczajona do hiperboli, ale biorąc pod uwagę szybkie postępy w tej dziedzinie, ważne jest, aby użytkownicy wiedzieli, jak spojrzeć poza iluzję. Osiągnięcie statusu „super AI” jest trudnym wyzwaniem i jest mało prawdopodobne, aby Grok mógł to osiągnąć przy obecnej konfiguracji i szkoleniu.

Aby zademonstrować możliwości Groka, Elon Musk porównał swojego chatbota do małego LLM przeszkolonego w programowaniu. Nie trzeba dodawać, że nie była to uczciwa walka.

ElonMusk (@elonmusk) 5Nov2023

Grok vs typowy przykład GPT; Grok ma prawdziwe informacje, drugi nie.

Zagrożenie dezinformacją

LLM jest potężny, ale nie nieomylny. Bez rygorystycznych standardów odróżnienie faktów od fikcji może być niezwykle trudne. Najnowsza historia dostarcza mrożących krew w żyłach przykładów, takich jak chatboty wyszkolone na danych z 4chan i Tay, wczesny chatbot Microsoftu upoważniony do interakcji na Twitterze. Boty te nie tylko szerzyły mowę nienawiści, ale także przekonująco podszywały się pod prawdziwych ludzi i oszukiwały wielu odbiorców online.

W tym tygodniu model tworzenia obraźliwych i dyskryminujących tekstów @huggingface został opublikowany na AI i zamieścił już ponad 30 000 nikczemnych komentarzy w sieci (według jego autora).

Ten eksperyment nigdy nie przejdzie przez komisję badań nad ludzkim ciałem Poniżej znajdują się moje sugestie.

1/7 https://t.co/tJCegPcFan pic.twitter.com/Mj7WEy2qHl

– Lauren Oakden-Rayner ️ ⚧️ (@DrLaurenOR) 6 czerwca 2022

Ten flirt z dezinformacją nie jest odosobnionym przypadkiem. Wizerunek Twittera pogorszył się od czasu nominacji Elona, co może podważać zdolność Glocka do dostarczania konsekwentnie dokładnych informacji. Ludzie z wykształceniem humanistycznym są czasami ofiarami iluzji, a kiedy te zniekształcenia są traktowane jako prawda, konsekwencje mogą być alarmujące.

Potencjał dezinformacji to bomba zegarowa. Ponieważ użytkownicy w coraz większym stopniu polegają na sztucznej inteligencji w zakresie informacji, dezinformacja może prowadzić do błędnych decyzji. Aby być zaufanym sojusznikiem, Glock musi postępować ostrożnie i upewnić się, że jego żartobliwość nie przyćmiewa prawdy.

Brak możliwości multimodalnych?

W rozwijającym się świecie sztucznej inteligencji, tekstowe podejście Groka wydaje się być reliktem przeszłości. Użytkownicy muszą płacić za usługi Grok, ale naturalne jest zastanawianie się, dlaczego, skoro inne LLM oferują bogatsze, multimodalne doświadczenia.

Na przykład GPT-4-v poczynił już ogromne postępy w multimodalności, pozwalając użytkownikom słyszeć, widzieć i mówić. Nadchodzący Gemini firmy Google obiecuje podobne możliwości. W tym kontekście propozycja Grok wygląda raczej nijako i budzi dalsze wątpliwości co do ich propozycji wartości.

Rynek jest wysoce konkurencyjny, a użytkownicy są coraz bardziej wymagający; jeśli Grok chce wyrzeźbić niszę, musi zaoferować coś naprawdę wyjątkowego. Biorąc pod uwagę, że konkurenci oferują zaawansowane funkcje i lepszą dokładność, często za darmo, Grok ma przed sobą nie lada zadanie.

Zakończenie

Uruchomienie Groka wywołało entuzjazm, ale także sceptycyzm: podejście oparte na Minimum Viable Product (MVP) pozwala na szybką iterację i ulepszanie w oparciu o opinie użytkowników. Jednak konkurencja ze strony gigantów sztucznej inteligencji, którzy dysponują znacznie większymi zasobami, jest trudna.

Aby odnieść sukces, Grok musi oferować nowe i przydatne funkcje. Na zatłoczonym rynku sama wartość rozrywkowa nie wystarczy. Ludzie zajmujący się sztuczną inteligencją nie będą rozpraszani przez słodkie memy o psach.

Ostatecznie los Grok zależy od równowagi między innowacyjnością a użytecznością. Chociaż zdrowy sceptycyzm jest uzasadniony, przedwczesne byłoby całkowite porzucenie firmy; Grok może nadal przełamywać nowe szlaki lub może skończyć jako przypis w rozwoju sztucznej inteligencji. Tak czy inaczej, jego niekonwencjonalne pochodzenie gwarantuje, że Grok będzie fascynującym rozdziałem w historii sztucznej inteligencji