Huawei дебютира на изложението GITEX GLOBAL 2023 миналата седмица с новия си модел за съхранение на изкуствен интелект (AI) – OceanStor A310, с което се опитва да отговори на някои предизвикателства в индустрията, свързани с големите приложения за модели. Проектиран за ерата на големите модели на изкуствения интелект, OceanStor A310 има за цел да предостави решение за съхранение на данни за обучение на основни модели, обучение на индустриални модели и изводи в модели със сегментиран сценарий.

Представете си OceanStor A310 като свръхефективен библиотекар в огромна цифрова библиотека, който бързо извлича части от информация. За сравнение, друга система – ESS 3500 на IBM – е по-бавна библиотекарка. Колкото по-бързо OceanStor A310 може да извлича информация, толкова по-бързо могат да работят приложенията на изкуствения интелект, вземайки своевременно интелигентни решения. Този бърз достъп до информация е това, което отличава OceanStor A310 на Huawei.

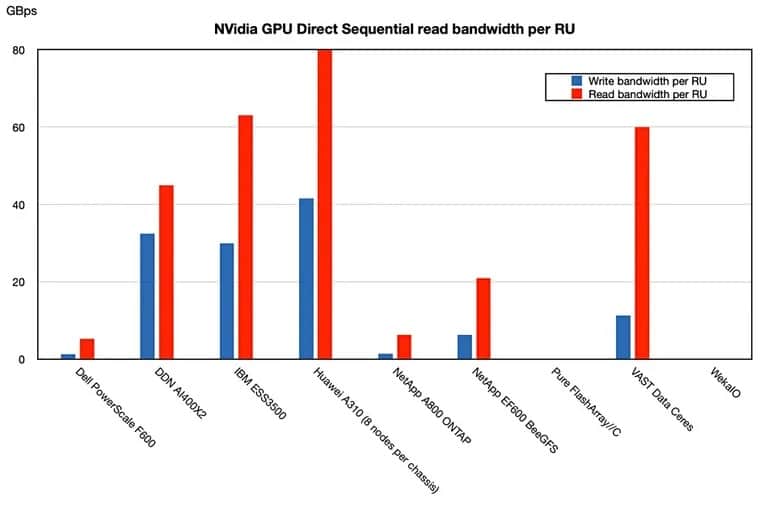

Предимството на OceanStor A310 изглежда се крие в способността му да ускорява обработката на данни за ИИ. В сравнение с ESS 3500 на IBM, най-новият all-flash масив на Huawei според съобщенията захранва графичните процесори на Nvidia почти четири пъти по-бързо на база единица решетка. Това е според методологията, използваща Magnum GPU Direct на Nvidia, при която данните се изпращат директно от ресурса за съхранение NVMe към графичните процесори, без да се включва хост система за съхранение.

OceanStor A310 на Huawei демонстрира производителност с до 400 GBps пропускателна способност за последователно четене и 208 GBps пропускателна способност за запис. Влиянието на рамките с отворен и затворен код върху тези цифри обаче остава неясно.

Потапяйки се в неговия механизъм, OceanStor A310 е проектиран като решение за съхранение на данни в езеро за дълбоко обучение, което потенциално предлага неограничена хоризонтална мащабируемост и висока производителност за смесени работни натоварвания.

„Знаем, че за приложенията на изкуствения интелект най-голямото предизвикателство е да се подобри ефективността за обучение на моделите на изкуствения интелект“, каза Еванджелин Уанг, продуктов мениджмънт и маркетинг на Huawei, в изявление, споделено от технологичното издание Blocks and Files. „Най-голямото предизвикателство за системата за съхранение по време на обучението на ИИ е да продължи да подава данни към централния процесор, към графичните процесори“, добави тя. „Това изисква системата за съхранение да осигури най-добрата производителност.“

За да се справи с този проблем, всеки OceanStor може да поддържа до 96 NVMe SSD-та, процесори и кеш памет. Потребителите могат да клъстерират до 4096 A310, като споделят глобална файлова система, която поддържа стандартни протоколи за приложения. OceanStor A310 има за цел да сведе до минимум времето за предаване на данни чрез SmartNIC и масивно паралелен дизайн.

„A310 на Huawei, със своите малки възли, беше най-бърз като цяло както при последователно четене, така и при писане, със своите 41,6/80 GBps пропускателна способност за последователно писане/четене спрямо цифрите 30/63 GBps на IBM.“ Block and Files заяви в сравнително проучване, което сравнява решението на Huawei с неговите преки конкуренти.

Изображение: Blocks and Files

Представянето на OceanStor A310 идва в момент, когато индустрията за изкуствен интелект търси ефективни решения за съхранение и обработка на данни. Това усилие на Huawei има за цел да отговори на някои от настоящите предизвикателства и може да допринесе за постигането на рационализирано обучение на модели на ИИ.

Санкциите на Съединените щати срещу Huawei – главно поради опасения, свързани с националната сигурност и предполагаемите връзки на компанията с китайското правителство – обаче усложняват начинанието на Huawei в областта на решенията за съхранение на данни за ИИ.

Потенциалните последици от OceanStor A310 на Huawei могат да бъдат значителни. Предлагайки решение за някои от настоящите неефективности в съхранението и обработката на данни, Huawei се опитва да предизвика другите доставчици и да тласне индустрията на ИИ към нова ера на възможни иновации и ефективност.