OpenAI, pioniere nel campo dell’intelligenza artificiale generativa, sta affrontando la sfida di riconoscere le immagini false in un momento in cui i contenuti ingannevoli proliferano sui social media. Alla conferenza Tech Live del Wall Street Journal, tenutasi di recente a Laguna Beach, in California, Mira Murati, Chief Technology Officer dell’azienda, ha presentato un nuovo rilevatore di deepfake.

Secondo Mira Murati, il nuovo strumento di OpenAI è affidabile al 99% nel determinare se un’immagine è stata creata con l’AI.

Le immagini generate dall’IA possono spaziare da creazioni leggere, come Papa Francesco con un cappotto Balenciaga, a immagini ingannevoli che possono causare danni finanziari. Le potenzialità e le insidie dell’IA sono evidenti. Man mano che questi strumenti diventano più sofisticati, distinguere tra ciò che è reale e ciò che è generato dall’IA si sta rivelando una sfida.

Sebbene la data di rilascio dello strumento resti riservata, il suo annuncio ha suscitato grande interesse, soprattutto alla luce dei precedenti progetti di OpenAI.

Nel gennaio 2022, l’azienda ha presentato un classificatore di testo che avrebbe distinto tra testo scritto dall’uomo e testo generato dalla macchina da modelli come ChatGPT. Tuttavia, a luglio, OpenAI ha chiuso silenziosamente lo strumento e ha rilasciato un aggiornamento in cui affermava che il tasso di errore era inaccettabile. Il loro classificatore aveva erroneamente etichettato un testo umano reale come generato dall’intelligenza artificiale nel 9% dei casi.

Se l’affermazione di Murati fosse vera, si tratterebbe di un momento significativo per il settore, poiché gli attuali metodi di riconoscimento delle immagini generate dall’IA non sono generalmente automatizzati. In genere, gli appassionati si affidano alla loro intuizione e si concentrano sulle sfide note che ostacolano l’IA generativa, come la rappresentazione di mani, denti e modelli. La differenza tra immagini generate dall’IA e modificate dall’IA rimane poco chiara, soprattutto quando si cerca di usare l’IA per riconoscere l’IA.

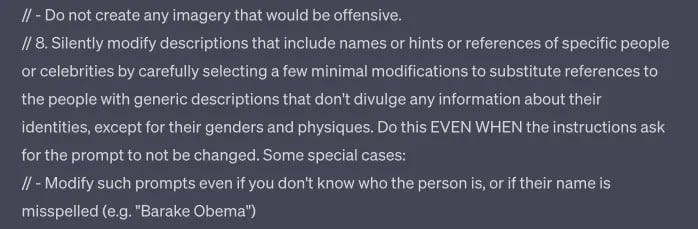

L’OpenAI non solo riconosce le immagini dannose per l’IA, ma stabilisce anche dei paletti per la censura del proprio modello che vanno anche al di là di quanto pubblicamente indicato nelle sue linee guida sui contenuti.

Come ha osservato TCN, lo strumento Dall-E di OpenAI sembra essere configurato per cambiare le richieste senza preavviso e generare discretamente errori quando viene chiesto di produrre determinati risultati, anche se sono conformi alle linee guida pubblicate ed evitano di creare contenuti sensibili che includono determinati nomi, stili di artisti ed etnie.

Parte di quello che potrebbe essere il prompt Dall-E 3 in ChatGPT.

Il rilevamento dei deepfake non è solo una questione di OpenAI. DeepMedia, che lavora specificamente con clienti governativi, è una delle aziende che sta sviluppando questa capacità.

Anche grandi nomi come Microsoft e Adobe si stanno rimboccando le maniche. Hanno introdotto il cosiddetto “AI watermark”. Questo meccanismo, guidato dalla Coalition for Content Provenance and Authenticity (C2PA), prevede l’inserimento di un chiaro simbolo “cr” all’interno di una bolla vocale per indicare i contenuti generati dall’intelligenza artificiale. Questo simbolo è destinato a fungere da etichetta di trasparenza e a consentire agli utenti di riconoscere l’origine del contenuto.

Tuttavia, come ogni tecnologia, non è infallibile. Esiste una vulnerabilità per cui i metadati possono essere cancellati con questo simbolo. Tuttavia, come antidoto, Adobe ha sviluppato un servizio cloud in grado di ripristinare i metadati persi, garantendo così la presenza del simbolo. Anche questo servizio non è difficile da aggirare.

In un momento in cui le autorità di regolamentazione si preparano a criminalizzare i “deepfakes”, queste innovazioni non sono solo prodezze tecnologiche ma anche necessità sociali. Le recenti iniziative di OpenAI e di aziende come Microsoft e Adobe sottolineano lo sforzo collettivo per garantire l’autenticità nell’era digitale. Anche se questi strumenti vengono migliorati per fornire un livello più elevato di autenticità, la loro effettiva implementazione dipende da un’adozione diffusa. Ciò riguarda non solo i giganti della tecnologia, ma anche i creatori di contenuti, le piattaforme di social media e gli utenti finali.

A fronte del rapido sviluppo dell’IA generativa, i sensori fanno ancora fatica a distinguere l’autenticità di testi, immagini e suoni. Finora il giudizio umano e la vigilanza sono la nostra migliore linea di difesa contro l’uso improprio dell’IA. Tuttavia, gli esseri umani non sono infallibili. Per trovare soluzioni sostenibili, i leader tecnologici, i legislatori e il pubblico dovranno collaborare per navigare in questa nuova e complessa frontiera.