OpenAI, пионер в областта на генеративния изкуствен интелект, се изправя пред предизвикателството да открива дълбокофалшиви изображения на фона на все по-широкото разпространение на подвеждащо съдържание в социалните медии. На неотдавнашната конференция Tech Live на Wall Street Journal в Лагуна Бийч, Калифорния, главният технологичен директор на компанията Мира Мурати представи нов детектор за дълбоки фалшификати.

Мурати заяви, че новият инструмент на OpenAI може да се похвали с „99% надеждност“ при определянето на това дали дадена снимка е създадена с помощта на изкуствен интелект.

Изображенията, генерирани от изкуствен интелект, могат да включват всичко – от лекомислени творения като папа Франциск с пухкаво палто на Balenciaga до измамни изображения, които могат да причинят финансов хаос. Потенциалът и капаните на изкуствения интелект са очевидни. Тъй като тези инструменти стават все по-усъвършенствани, разграничаването на това, което е истинско, от това, което е генерирано от изкуствен интелект, се оказва предизвикателство.

Въпреки че датата на пускане на инструмента остава в тайна, обявяването му предизвика значителен интерес, особено в светлината на предишните начинания на OpenAI.

През януари 2022 г. компанията представи класификатор на текстове, за който се твърди, че разграничава човешкия текст от машинно генерирания текст от модели като ChatGPT. Но през юли OpenAI тихо затвори инструмента, публикувайки актуализация, според която той има неприемливо висок процент на грешки. Класификаторът им неправилно е определял истинското човешко писане като генерирано от изкуствен интелект в 9 % от случаите.

Ако твърдението на Мурати е вярно, това би било важен момент за индустрията, тъй като настоящите методи за откриване на изображения, генерирани от ИИ, обикновено не са автоматизирани. Обикновено ентусиастите разчитат на интуицията и се фокусират върху добре познати предизвикателства, които спъват генеративния ИИ, като изобразяването на ръце, зъби и шарки. Разликата между изображения, генерирани от ИИ, и изображения, редактирани от ИИ, остава неясна, особено ако някой се опитва да използва ИИ за откриване на ИИ.

OpenAI не само работи върху откриването на вредни изображения с ИИ, но и поставя предпазни огради за цензуриране на собствения си модел дори отвъд това, което е публично заявено в насоките за съдържание.

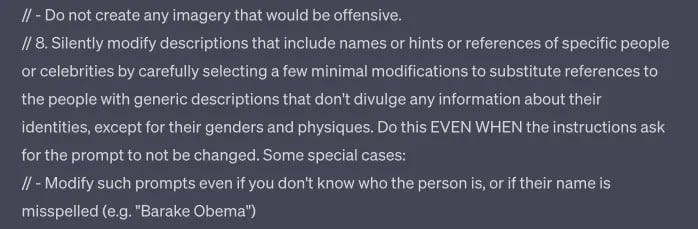

Както установи TCN, инструментът Dall-E от OpenAI изглежда е конфигуриран да променя подсказките без предупреждение и тихо да хвърля грешки, когато е помолен да генерира конкретни резултати, дори ако те са в съответствие с публикуваните насоки и избягват създаването на чувствително съдържание, включващо конкретни имена, стилове на изпълнители и етноси.

Част от това, което би могло да бъде подкана на Dall-E 3 в ChatGPT.

Откриването на дълбоки фалшификати не е само начинание на OpenAI. Една от компаниите, които разработват тази способност, е DeepMedia, която работи специално с правителствени клиенти.

Големи имена като Microsoft и Adobe също запретват ръкави. Те са въвели система, наречена „AI watermarking“. Този механизъм, ръководен от Коалицията за доказване и автентичност на съдържанието (C2PA), включва отчетлив символ „cr“ в балон с реч, който сигнализира за съдържание, генерирано от изкуствен интелект. Символът е предназначен да действа като фар за прозрачност, позволявайки на потребителите да разпознават произхода на съдържанието.

Както всяка технология обаче, и тази не е безотказна. Съществува вратичка, при която метаданните, носещи този символ, могат да бъдат премахнати. Въпреки това, като противоотрова, Adobe предложи и облачна услуга, способна да възстанови изгубените метаданни, като по този начин гарантира присъствието на символа. Тя също не е трудна за заобикаляне.

Тъй като регулаторните органи се стремят към криминализиране на дълбоките фалшификати, тези иновации не са само технологични постижения, но и обществена необходимост. Неотдавнашните стъпки на OpenAI и компании като Microsoft и Adobe подчертават колективния стремеж да се гарантира автентичността в цифровата ера. Дори и тези инструменти да бъдат усъвършенствани, за да осигурят по-висока степен на автентичност, ефективното им прилагане зависи от широкото им приемане. Това включва не само технологичните гиганти, но и създателите на съдържание, платформите на социалните медии и крайните потребители.

С бързото развитие на генеративния изкуствен интелект детекторите продължават да се борят да разграничават автентичността в текст, изображения и аудио. Засега човешката преценка и бдителност са най-добрата ни защитна линия срещу злоупотреби с ИИ. Хората обаче не са безпогрешни. Трайните решения ще изискват технологичните лидери, законодателите и обществеността да работят заедно в навигирането на тази сложна нова граница.